Desde que ChatGPT apareció en escena, muchas personas han decidido incorporarlo en su flujo de trabajo. La inteligencia artificial (IA) del chatbot se ha convertido en una gran aliada de la oficina por su capacidad para ayudar en tareas de programación, redactar correos electrónicos, elaborar resúmenes, analizar datos y generar gráficos.

El entusiasmo por utilizar esta herramienta desarrollada por OpenAI para dar un salto en la productividad puede llegar acompañada de un problema. Sin pretenderlo, algunos usuarios quizá estén exponiendo ciertos datos confidenciales propios o de la empresa para la que trabajan. ¿El motivo? ChatGPT, por diseño, no sabe guardar secretos.

ChatGPT en el trabajo, un arma de doble filo

Pongamos como ejemplo la siguiente situación. Trabajas en una empresa y dentro de un par de horas deberás asistir a una reunión. En el encuentro se discutirá la estrategia comercial de la firma para el año próximo. Para preparar mejor tu intervención decides apuntarte los ítems más importantes del documento anual de planificación.

El documento en cuestión tiene información confidencial que, en caso de filtrarse, podría tener consecuencias negativas para tu empresa. Hay secciones donde se analiza a la competencia y otras donde se mencionan productos que ni siquiera han sido lanzados. Pero tienes poco tiempo para leerlo, así que dices hacer un resumen con ChatGPT.

Una tabla creada por ChatGPT

Una tabla creada por ChatGPT

Subes el PDF al chatbot, obtienes los puntos clave que necesitabas y tu intervención en la reunión es un éxito. Pues no solo estabas completamente informado de tu área en particular, sino que tenías una visión global de hacia dónde apunta la compañía a la que perteneces. Ahora bien, esa información podría caer en manos equivocadas.

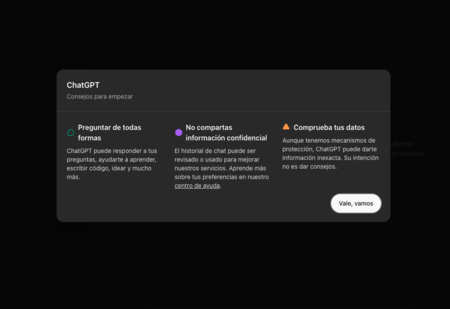

Cuando utilizamos ChatGPT por primera vez, una ventana emergente nos recomienda no compartir información confidencial. En ocasiones, sin embargo, solemos presionar en Aceptar sin ser completamente conscientes de lo que esto significa. Los empleados de OpenAI podrían ver el contenido e incluso este podría ser utilizado para mejorar el chatbot.

La ventana emergente de ChatGPT con sugerencias de uso

La ventana emergente de ChatGPT con sugerencias de uso

Esto que acabamos de mencionar está detallado en la política de uso de datos de la compañía liderada por Sam Altman. OpenAI deja en claro que puede utilizar las indicaciones del usuario, las respuestas, las imágenes y los archivos para mejorar el rendimiento del modelo subyacente, es decir, GPT-3.5, GPT-4, GPT-4o o versiones futuras.

La forma de mejorar los modelos es entrenándolos con más información para que cuando alguien pregunte sobre un tema pueda brindar una respuesta más precisa. Así que, a menos que se hayan tomado algunos recaudos que veremos a continuación, se podría estar entrenado el modelo con datos confidenciales.

El peligro, no obstante, no radica únicamente en que ChatGPT pueda acabar filtrando secretos comerciales o de cualquier otro tipo. Una vez que los datos están en los servidores de OpenAI, los mismos pueden ser visualizados por empleados de la compañía o “proveedores de servicios de confianza” autorizados por diversos motivos.

Hay cuatro escenarios en los que otras personas pueden acabar viendo tu historial de actividad con el chatbot.

- Para investigar incidentes de seguridad.

- Para brindar asistencia que has solicitado.

- Para responder a asuntos legales.

- Para mejorar el rendimiento del modelo.

Este escenario ha llevado a compañías como Samsung a tomar medias para evitar que datos confidenciales acaben siendo filtrados. Por ejemplo, se ha limitado el uso del chatbots para ciertas tareas y se han implementado versiones corporativas que prometen no utilizar los datos de las conversaciones para tareas de entrenamiento.

Como mejorar la seguridad de los datos en ChatGPT

Los usuarios y las empresas tienen a su alcance dos alternativas concretas que, según promete OpenAI, permitirán proteger sus datos confidenciales: deshabilitar la opción de mejora del modelo con las conversaciones o utilizar una de las versiones empresariales de ChatGPT. Veamos detenidamente cómo utilizar cada una.

Si usas ChatGPT o ChatGPT Plus y quieres evitar que tus conversaciones sean utilizadas para entrenar modelos de OpenAI, puedes seguir los siguientes pasos:

La ventana para desactivar el entrenamiento

La ventana para desactivar el entrenamiento

- Abre ChatGPT desde un ordenador.

- Pulsa en fu foto de perfil y después en Configuración.

- Pulsa en Controles de datos y después en Mejorar el modelo para todos.

- Asegúrate que el interruptor de Mejorar el modelo para todos esté desactivado.

Si trabajas en un ámbito profesional y usas las soluciones de pago ChatGPT Enterprise o ChatGPT Team, en todos los casos los datos no se utilizan para entrenar modelos de OpenAI. Adicionalmente, los mismos están protegidos por cifrado de datos en reposo (AES-256) y en tránsito (TLS 1.2+).

Tus chats todavía pueden ser vistos

Incluso utilizando algunas de las herramientas profesionales de pago mencionadas anteriormente, existen casos puntuales donde personas externas a tu empresa pueden ver las conversaciones.

En el caso de ChatGPT Enterprise, los empleados de OpenAI pueden acceder a las conversaciones para resolver incidentes, recuperar conversaciones de usuarios, siempre y cuando tengan su permiso, o cuando lo solicite la justicia.

En el caso de ChatGPT Team, los empleados de OpenAI pueden acceder a las conversaciones “para dar soporte de ingeniería”, investigar posibles abusos y garantizar el cumplimiento legal. Aquí entran en escena también “contratistas externos especializados” que pueden ver las conversaciones en escenarios de abuso o uso indebido.

Los empleados o actores externos de OpenAI que en todos los casos pueden ver las conversaciones de los usuarios de ChatGPT están sujetos a obligaciones de confidencialidad y seguridad. No caben dudas de que esto último es un recurso importante que ayuda a mantener cualquier tipo de datos que vean a salvo de miradas ajenas.

Sin embargo, no debemos perder de vista que estamos hablando de humanos. En el mundo empresarial hemos visto que las obligaciones de confidencialidad no suelen ser 100% efectivas. Uno de los ejemplos más claros que encontramos en este ámbito son las filtraciones de productos o servicios que surgen de las propias compañías.

Imágenes | OpenAI | Capturas de pantalla

Ver 6 comentarios